SEO Auslese Oktober 2018

Während Google im September seinen 20. Geburtstag feierte und es jede Menge Neuigkeiten gab, so war der Oktober etwas ruhiger. Im Gepäck unserer SEO Auslese haben wir Googles Fazit zum Eintritt in den chinesischen Markt, die neue Version von reCAPTCHA und die Follow-Funktion für Unternehmensseiten in Google Maps.

Außerdem haben wir für euch eine Case Study zu gutefrage.net und zur Vertrauenswürdigkeit des Suchvolumens im Keyword Planer zusammengefasst. Lehnt euch also entspannt zurück und lest alle wichtigen SEO-Neuigkeiten aus dem Oktober in unserer Auslese.

News der Suchmaschinen

Wichtigkeit der Seitenladezeit für Google

Wie wichtig die Seitenladezeit für Google ist, zeigt sich in den Nachrichten, die seit kurzem an Website-Betreiber mit sehr schlechten Ladezeiten versendet werden. Die Nachrichten enthalten Hinweise zu folgenden Kennzahlen und verweisen dabei auf das Lighthouse Plugin.

- First Contentful Paint: Der erste Hinweis für den Nutzer, dass auf der Seite etwas geladen wird, also das Rendering startet.

- Time to Interactive: Zeit, nach der mit der Seite interagiert werden kann.

- First Input Delay: Reaktionszeit des Browsers nachdem ein Nutzer auf z.B. einen Link geklickt, also mit der Webseite interagiert hat.

Googles Fazit zum Eintritt in den chinesischen Markt

Wie der eine oder andere vielleicht schon mitbekommen hat, entschied sich Google zuletzt für den Eintritt in den chinesischen Markt. Speziell dafür wurde eine zensierte Search Engine entwickelt, um den Ansprüchen der chinesischen Regierung gerecht zu werden. Dennoch musste das Unternehmen massenweise Kritik über sich ergehen lassen. Google selbst hat nun ein Fazit nach der ersten Testphase gezogen und ist prinzipiell zufrieden mit den Ergebnissen:

“It turns out we’ll be able to serve well over 99 percent of the queries,” that users request.

Als Begründung für diesen Schritt hieß es:

“People don’t understand fully, but you’re always balancing a set of values. Those values include providing access to information, freedom of expression, and user privacy. But we also follow the rule of law in every country.”

Lohnt sich die Mühe, individuelle Descriptions zu hinterlegen?

Im April 2018 veröffentlichte Yoast eine Studie, die zeigte, dass 2/3 der Meta-Descriptions nicht aus den hinterlegten Meta-Angaben genutzt werden. Vielmehr nutzte Google den ersten Absatz der Webseite. Website-Betreiber sollten daher prüfen, ob der erste Absatz auf ihren Webseiten sinnvollen Inhalt enthält.

Nun hat sich John Müller dazu geäußert und empfiehlt, die Descriptions individuell zu gestalten, wenn Kapazitäten dafür vorhanden sind. Letztendlich kennt der Website-Betreiber seine Seite besser als Google. Die Vermutung liegt nahe, dass Google selbst ausgewählte Descriptions nutzt, wenn die eigentlichen Snippets schlecht geklickt werden.

Vergangenes Google Update beschäftigt Branche weiterhin

Das Thema Core-Update aus dem August flacht nicht ab. Nun schrieb SEO Südwest einen Artikel dazu und bezog sich zudem auf das weitere Update im Oktober:

- YMYL-Websites waren vom Core-Update verstärkt betroffen.

- Durch das Update im Oktober konnten die betroffenen Websites eine gegenläufige Entwicklung der Rankings verzeichnen.

- Sistrix fand heraus, dass 60% der betroffenen Websites ebenfalls vom Penguin Update 2012 betroffen waren.

- Sistrix hat diese Seiten genauer untersucht und fand heraus, dass viele davon noch unnatürliche Linktexte aufweisen, um für diese Keywords zu ranken, oder es handelt sich um „Money-Keywords“ (im medizinischen Bereich sind das bspw. „Diabetes“, „Schwangerschaft“ usw.)

- Google hat aber den Zusammenhang zwischen Core-Update und Penguin nicht kommentiert, daher bleibt es bei einer Vermutung.

Search Engine Roundtable hat in einem Artikel ebenfalls Bezug dazu genommen: Die technischen Updates werden laut Barry Schwartz nun durch EAT-Updates (siehe Google Quality Rater Guidelines: Expertise – Authoritativeness – Trustworthiness) ersetzt. An guten Inhalten führt also nichts vorbei. Die technische Optimierung ist selbstverständlich geworden. Nur mit Backlinks und guten Inhalten könne die oberste Position in den Suchergebnissen erreicht werden.

Google präsentiert reCAPTCHA v3

Jeder kennt es: Man will eine bestimmte Aktion auf einer Website ausführen, muss aber erstmal per CAPTCHA-Abfrage einen Zahlencode eingeben oder alle Bilder mit Verkehrszeichen bestimmen. Für den Nutzer nervig, aber für Website-Betreiber ein Hilfsmittel, um Bots fernzuhalten. Nun sollen diese lästigen Testaufgaben der Vergangenheit angehören, denn Google hat an einer neuen Version der Technologie gearbeitet: „reCAPTCHA v3“.

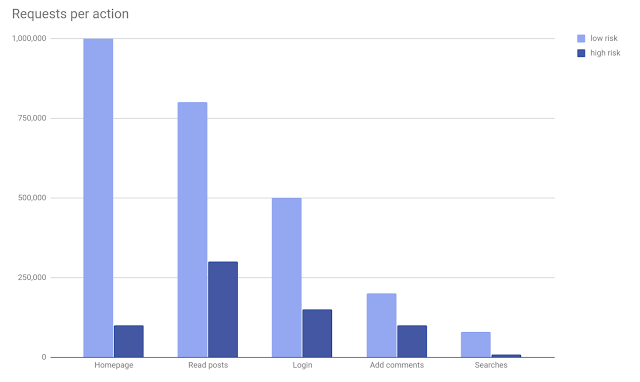

Die neue Technologie soll im Hintergrund laufen und dem Website-Betreiber eine Bewertung zu den (verdächtigen) Interaktionen auf seiner Website geben. Über die Admin-Konsole können diese Analysen eingesehen werden. Damit kann der Betreiber einer Website nun durch die Bewertung und dem Festlegen bestimmter Einstellungen selbst die Nutzererfahrung beeinflussen.

IP-Adresse für Ranking unrelevant

Kürzlich stellte sich John Müller Fragen zur Relevanz der IP-Adresse auf Twitter. Demnach ist Google die IP-Adresse bezogen auf den Server-Standort einer Website soweit egal. Konkret ging es in dem Austausch darum, dass die Website eines US-amerikanischen Unternehmens aus Utah wohl eine IP-Adresse hatte, die Australien zugeordnet wird. Auf die Frage, ob das eine Auswirkung auf das Ranking hat, antwortete John Müller ganz schlicht: „Nope“.

Search Console Statistiken direkt auf Suchergebnisseite beobachtet

Einigen Beobachtungen zufolge zeigt Google verifizierten Website-Inhabern Kennzahlen aus der Search Console direkt auf der Suchergebnisseite an. Klicks, Impressionen und die durchschnittliche Position werden dabei zur eingegebenen Suchanfrage angezeigt. Ob es sich um einen Test handelt oder dieses Feature bald weitläufig ausgerollt wird, ist noch nicht bekannt.

Not seen this before, Search Console metrics directly in the SERP when you perform a query. @rustybrick is this new?

— Simon Glanville (@simon_glanville) 04. Oktober 2018

Neue Darstellung von Sitelinks im Test

Google testet eine neue Darstellungsform von Sitelinks. SEMrush hat dies beobachtet und auf Twitter geteilt. Bei einigen Suchanfragen werden die Sitelinks nun als ausklappbare Elemente unter dem Suchergebnis angezeigt und enthalten weitere Infos.

Local SEO News

Google Maps ermöglicht das Folgen von Unternehmensseiten

Google rollt in den kommenden Wochen eine neue Funktion aus, mit denen User in der Google Maps Suche einzelnen Anbieter-Seiten folgen können. Wie aus Social Media bekannt, wird man im Anschluss über Neuigkeiten, Angebot und Events der Seite informiert. Für Unternehmen bietet die Funktion ein hohes Potential, den Nutzer im lokalen Kontext abzuholen und schneller zur Conversion (z.B. dem Besuch des Geschäfts) anzuregen.

Unternehmen können bereits 3 Monate vor Öffnung einen Google My Business Eintrag anlegen und dieser erscheint dann auch schon in der lokalen Suche. Die Follow-Funktion verleiht dieser Möglichkeit dementsprechend noch mehr Potential, Nutzer von Anfang an auf dem Laufenden zu halten.

Google passt Design für Desktop-Hotelsuche an mobiles Design an

In der lokalen Suche nach Hotels auf dem Desktop bekommt der Nutzer nun dasselbe Design zu sehen wie in der mobilen Suche. Diese wurde bereits vor einigen Monaten angepasst. Die Neuerungen enthalten:

- Fotos vom Hotel und anderen Reisenden

- Informationen zu Umgebung und Lage

- Bewertungen, die nach Stichworten durchgesucht werden können

- Detaillierte Beschreibung zum Hotel

- Preisvergleich unter Einbeziehung verschiedener Buchungsseiten

Branchen Insights

Wie Gutefrage.net 150% an Sichtbarkeit gewinnen konnte

Searchmetrics hat zusammen mit gutefrage.net eine spannende Case Study veröffentlicht. Darin wird beschrieben, wie ein durchdachtes Content Audit entwickelt wurde, um nur relevante Inhalte für die Google-Suche zu identifizieren und wie mit Hilfe des Google Updates im August 2018 die Sichtbarkeit dann um 150% gesteigert werden konnte. Wer die Plattform kennt, weiß, dass eine starke Abhängigkeit durch die von Nutzern generierten Inhalte und daher eine besonders große Herausforderung in der Bewältigung der Millionen Inhalte besteht. Gutenfrage.net legte zunächst längere Zeit keinen großen Wert auf SEO, was sich in einem durch Google Updates hervorgerufenen Abwärtstrend in der Sichtbarkeit äußerte.

Daher entwickelte die Plattform gemeinsam mit Searchmetrics eine SEO Strategie. Ziel war und ist es, nur noch qualitativ hochwertige Inhalte im Google Index zu haben und zudem die Suchintention der Nutzer zu befriedigen. 16 Millionen indexierte Seiten zu bewerten und aufzuräumen – das war die erste Herausforderung, der man sich gemeinsam stellen musste. Dass dies nicht ohne automatisierte Prozesse zu bewältigen ist, wird schnell klar. Der bereits vorhandene „Quality Answer Score“ war dabei ein entscheidendes Hilfsmittel für die Analyse der bestehenden Inhalte. Zudem wurde jede Antwort anhand verschiedener Kriterien (z.B. Länge der Inhalte, positive Reputation der Nutzer) bewertet, ergänzt durch eine semantische Analyse zur Hochwertigkeit der beantworteten Frage. Fragen, die niemals beantwortet wurden, werden dabei als Thin Content Seiten eingestuft und sollen direkt aus dem Index verschwinden.

Das Verfahren identifizierte 11 Millionen Seiten, die anschließend über Monate hinweg Schritt für Schritt aus dem Google Index entfernt wurden. Somit hatte man nun eine saubere Basis an relevanten Inhalten für den Nutzer. Die zweite Herausforderung bestand darin, den Google Quality Rater Guidelines gerecht zu werden, denn gutefrage.net hat viel mit den von Google als YMYL (Your Money or Your Life) klassifizierten Themen zu tun. Um diese Themen zu betreuen und eine manuelle Qualitätsbewertung zu garantieren, wurden externe Experten und Partner engagiert, die eine hohe Reputation haben. Diese können sofort auf YMYL-Themen reagieren und somit eine hohe Qualität der Inhalte der beantworteten Fragen gewährleisten.

Außerdem wurden weitere technische Details optimiert. Letztendlich führte diese Strategie mit dem Core Update im August 2018 zu einem Anstieg der Searchmetrics Sichtbarkeit um 150%.

Untersuchung zur Verlässlichkeit des Suchvolumens im Keyword Planer

Claas Kalwa hat sich im Xovi Blog mit der Verlässlichkeit des Suchvolumens im Google Keyword Planer beschäftigt. Der Beitrag stellt neben den bereits vorhandenen Untersuchungen durch moz oder ahrefs noch einmal heraus, dass das Suchvolumen deutlich komplexer ist, als manch einer annimmt.

Für Suchmaschinenoptimierer ist das Suchvolumen häufig der Indikator für die Auswahl von geeigneten Keywords bei der Recherche. Dennoch gibt es einige Tücken, die man im Hinterkopf behalten sollte:

Rundungen des Suchvolumens & saisonale Keywords

Das im Keyword Planer ausgegebene Suchvolumen spiegelt den Durchschnitt der letzten 12 Monate wieder und stellt daher mehr einen Vergleichswert und keinesfalls einen exakten Wert dar. Wer detaillierter werden möchte, kann einen Blick auf das monatliche Suchvolumen für das jeweilige Keyword werfen.

Bei saisonalen oder kurzzeitig im Trend liegenden Keywords ist besondere Vorsicht mit dem Suchvolumen geboten, wie am Beispiel „weihnachten“ beschrieben wird. Das Keyword hat zwar ein durchschnittliches Suchvolumen von 165.000, hat seinen „Peak“ aber mit 1.220.000 Suchanfragen im Dezember. Dennoch ist der von Google angegebene Durchschnitt ungenau bzw. gerundet, wenn man einen Blick auf das monatliche Suchvolumen wirft und beim selbst zusammenrechen auf 168.325 kommt. Grund für die Rundungen durch Google sind ca. 80 logarithmisch verteilte Klassen, denen die durchschnittlichen monatlichen Suchvolumen sowie die monatlichen Suchvolumen zugehören.

Zusammenführung für verwandte Suchbegriffe & Knowledge Graph

Es ist längst nicht mehr so, dass man im Keyword Planer zu jedem Keyword ein Suchvolumen erhält, da Google inzwischen für z.B. Singular- und Plural-Formen, Wörter in einer anderen Reihenfolge mit derselben Bedeutung oder Abkürzungen das Suchvolumen zusammenfasst. Außerdem hat Google für Oktober angekündigt, nun auch Keywords mit der gleichen Suchintention zusammenzufassen. Was für SEAs praktisch ist, stellt für SEOs eine Herausforderung dar. Im Artikel wird das am Beispiel der verschiedenen Schreibweisen für das Keyword „SEO“ verdeutlicht: amerikanisch „search engine optimization“, britisch „search engine optimisation“ – alle zusammengefasst ein Suchvolumen von 33.100. Aber: Die britische Variante dürfte viel weniger Suchanfragen haben. In diesem Fall hilft also nur Kopf einschalten und die am häufigsten nachgefragte Variante nutzen.

Ebenfalls mit beachtet werden sollte bei der Auswahl des richtigen Keywords, dass Google bestimmte Fragen bereits gut per Knowledge Graph direkt in den SERPs beantworten kann. Der Nutzer muss also gar nicht mehr erst die Website besuchen, was die Klickrate reduziert.

Vergleich mit Search Console & Google Trends Daten

Im Artikel wurde noch eine kleine eigene Untersuchung zur Genauigkeit des Suchvolumens vorgenommen, indem es mit den Impressionen aus der Google Search Console und Google Trends verglichen wurde. Ergebnis war, dass sich die Angaben einigermaßen ähnlich sind und sich die Abweichungen in akzeptablen Grenzen halten.

Fazit des Artikels ist, dass das Suchvolumen unter Beachtung der möglichen Fallstricke dennoch die valideste Quelle zur Bewertung eines Keywords ist.

Branchen News kurz & knapp

- Im Blog von com wird mittels eines eigenen Tests der Frage nachgegangen, ob sich eine hohe Anzahl Weiterleitungen in der .htaccess negativ auf die Performance der Webseite ausübt.

- Serpstat hat Sichtbarkeit und Marktanteil von Domains verschiedener Branchen (u.a. Immobilien, Elektronik) unter die Lupe genommen und die Ergebnisse in einer Studie zusammengefasst.

- T3n berichtet über die steigenden Suchanfragen der alternativen Suchmaschine Duckduckgo.

- Searchmetrics hat eine Studie zu Ranking-Faktoren in acht Nischen aus vier verschiedenen Branchen durchgeführt und stellt die Ergebnisse in einem Whitepaper zur Verfügung.

- Auch wenn in Deutschland noch nicht verfügbar, erklärt Markus Hövener schon einmal Schritt für Schritt, wie man das notwendige „JobPosting“ Markup für Google for Jobs manuell integrieren kann.

- Im Whiteboard Friday von moz werden alle SEO-relevanten Aspekte von Facetten-Navigationen beleuchtet.

- Welche Kennzahlen für die Bewertung von guten und schlechten Inhalten relevant sind und wie man ein Scoring daraus entwickelt, hat Felix von Seokratie zusammengefasst.