Bing gibt Gas! – Was können die neuen Features des Webmaster Tools und wie können wir SEOs sie nutzen?

Mit Abstand der ewige Zweite – mit diesem Schicksal muss sich die Bing-Suchmaschine schon lange zufriedengeben. Eine Suchmaschinenoptimierung lohnt sich da nur für die wenigsten Websites. Aber heißt das auch, wo kein Traffic, da kein gutes Webmaster Tool?

Seit Juli dieses Jahres hat Bing Webmaster Tools nicht nur einen neuen Anstrich, sondern auch einige neue Features. Und die lassen sich echt sehen!

Such-Performance

Auf den ersten Blick kann man schon ganz gut erkennen: Hier unterscheidet sich nicht allzu viel von Googles Search Console. Die Such-Performance bietet eine kompakte Übersicht zu den wichtigsten KPIs (Klicks, Aufrufe, durchschnittliche Klickrate und Position). Die Daten sind, wie auch bei Google, nicht tagesaktuell und lassen sich bis zu 6 Monate zurück nachvollziehen und anzeigen. Ein großes Manko ist die Tatsache, dass Bing hier keine Filterfunktionen bietet.

Filter wie Suchtyp, Land und Darstellung in der Suche, wie wir sie aus der Google Search Console kennen, sucht man hier vergebens. Das macht es schwierig, bei der aktiven Arbeit mit dem Bing Webmaster Tools Daten und Zeiträume miteinander zu vergleichen. Wenn man also keine Bestandsdaten bereits vorab irgendwo gespeichert hat, um zum Beispiel nachzuvollziehen, ob die Optimierungsmaßnahmen von vor fünf Monaten schon Früchte tragen, dann guckt man ganz schön aus der Webmaster-Wäsche.

Site Explorer

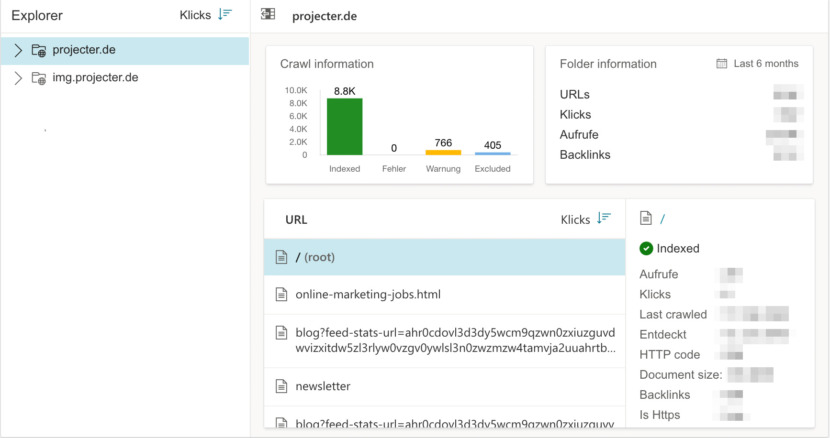

Der Site Explorer ist das neueste Analyse Tool aus dem Hause Microsoft. Seit Oktober 2020 steht die Beta Version im Webmaster Tools zur Verfügung. Die Übersicht zeigt, wie Bing die eigene Website sieht bzw. gesehen hat während der Indexierung. Es werden also auch Umleitungen, URLs, die von robots.txt Dateien blockiert werden, und defekte Links mit angezeigt. Die Ansicht des Site Explorers ist dem Datei Explorer von Microsoft nachempfunden und so aufgebaut, wie die Struktur der eigenen Website. Das macht die Orientierung und Navigation für die NutzerInnen besonders einfach. Auch über die Performance der jeweiligen Verzeichnisse gibt Bing Auskunft. Man erhält Informationen zu Klicks, Impressionen und Anzahl der Backlinks.

Gleichzeitig kann man auch innerhalb des Site Explorers eine Indexierung anfordern oder URLs mit der robots.txt Funktion testen.

Sitemaps

Im Sitemap-Report bekommt man einen Überblick von allen Sitemaps, die für eine Website von Bing erkannt wurden. Außerdem kann man nachvollziehen, wann Sitemaps das letzte Mal gecrawlt und mit welchem Status sie versehen wurden.

Das Einreichen der Sitemaps erfolgt einfach und unkompliziert als XML, RSS 2.0, Atom 0.3 und 1.0 sowie Textdateien. Man kann die Sitemaps aber auch direkt über die Webmaster Tools einreichen. Diese Funktion ermöglicht auch das erneute Einreichen von bereits gecrawlten Sitemaps.

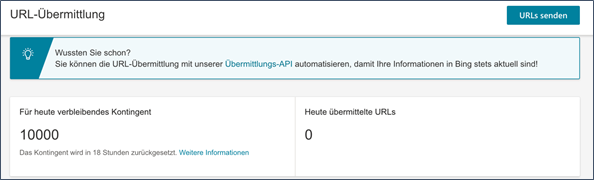

URL-Übermittlung

Bing ermöglicht seinen NutzerInnen nicht nur die Einreichung von kompletten Sitemaps, sondern auch von einzelnen URLs. Dazu stellt Bing ein Tageskontingent von 10.000 URLs zu Verfügung. Laut Webmaster Tools soll das manuelle Einreichen eine schnellere Indexierung anstoßen, also zum Beispiel denkbar bei aktualisierten URLs vom 302 zum 200 Status.

Ob und wann die eingereichten URLs tatsächlich gecrawlt wurden, lässt sich im BWT allerdings nicht nachvollziehen.

Backlinks

Mit der Backlinks-Funktion behält man verlinkende Domains und eingehende Links schnell und einfach im Blick. Das Menü ist „klickbar“ gestaltet, sodass man jede Quelldomain einzeln aufrufen kann. So erhält man eine Übersicht zu der jeweils verwendeten Ziel-URL und dem Ankertext, der eingesetzt wurde.

Bing hat seine Backlink-Übersicht allerdings noch um zwei weitere Funktionen erweitert:

Ähnliche Seite

Die BWT ermöglicht es, das eigene Backlink-Profil mit dem einer fremden Website zu vergleichen. Voraussetzung ist, dass man mit der eigenen Website registriert ist, Zugriff auf die Vergleichsseite benötigt man dazu nicht.

Links ablehnen

Mit dieser In-Tool-Lösung kann man direkt in den Webmaster Tools unerwünschte Links ablehnen. Schnell und unkompliziert kann man die Links direkt an Bing senden, die daraufhin unmittelbar abgelehnt werden.

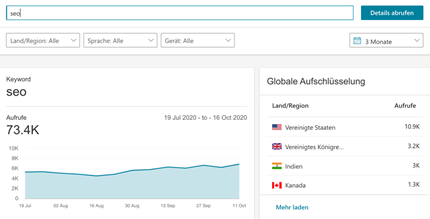

Keyword-Recherche

Keine neue, aber sehr gelungene In-Tool-Lösung: Bing hat sich die Keywordrecherche direkt in die Webmaster Tools geholt. Nachdem man in der Suchleiste sein präferiertes Keyword eingegeben hat, erhält man eine Übersicht zu den aktuellen Trends. Die Filtermöglichkeiten offenbaren auch, in welchen Ländern und auf welchen Sprachen das jeweilige Keyword rankt. Außerdem erhält man Information zu ähnlichen Suchbegriffen und Frage-Keywords. Zu guter Letzt werden auch Keywords angezeigt, die neu erkannt wurden, die also einen positiven Trend zeigen. Hier hat Bing eindeutig die Nase vorn. In der Google Search Console findet man eine Funktion dieser Art nicht.

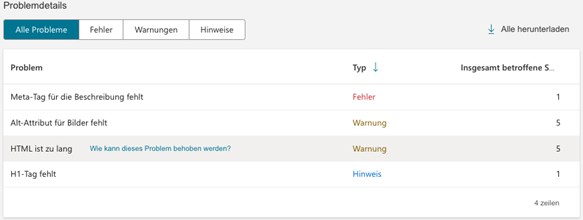

SEO-Berichte

Die Bing Reports werden automatisch alle 2 Wochen generiert. Die identifizierten Fehler werden NutzerInnen kompakt und übersichtlich aufbereitet und präsentiert. Die Einteilung nach Schweregrad verschafft einen schnellen Überblick über akute Probleme der Seite. Bing erklärt auf seiner Support-Seite, dass die Verbesserungsvorschläge auf den „15 SEO Best Practices“ basieren und sie, richtig angewandt, zu einem besseren Ranking verhelfen sollen.

Site Scan

Manuell gestartet kann man bis zu 10.000 Seiten im Monat auf technische SEO-Probleme überprüfen lassen. Nachdem Scan-Name und Scan-Volumen festgelegt wurden, fängt der Bot an, die URLs zu crawlen.

Nach Abschluss des Scans erhält man folgende Informationen:

- Den Status des Scans

- Die Zahl der gescannten Seiten

- Die Zahl der Fehler

- Die Zahl der Warnungen

Bing hat sich hier aber nicht lumpen lassen. Neben der Problem-Übersicht bekommt der Webmaster mit einem Klick auch die Problemlösung angezeigt. Sehr nutzerfreundlich und unterstützt bei jeder Detektiv-Arbeit.

Crawlsteuerung

Eine Crawlsteuerung kennen wir aus der Search Console nicht. Mit dem Webmaster Tools lässt sich der Bing-Bot aktiv steuern, indem man ihm Crawl-Zeiten vorgibt. In diesen festgelegten Zeiträumen crawlt der Bot mit geringerer Geschwindigkeit über die eigene Website. Also zum Beispiel zu den Zeiten mit dem höchsten Traffic.

Außerhalb dieser Zeiten wird in normaler Geschwindigkeit gecrawlt.

URLs blockieren

Auch hier hat Bing eine In-Tool-Lösung in petto. Innerhalb des Webmaster Tools kann man mit einem Klick Seiten- & Verzeichnis-URLs für 90 Tage aus dem Index entfernen. Bereits nach wenigen Minuten hat der Bing-Bot die eingereichten URLs aus den SERPs entfernt. Sobald die 90 Tage um sind oder man die Blockierung manuell wieder aufhebt, erscheinen die Seiten wieder in der Suche.

Robots.txt-Tester

Der Robots.txt-Tester hilft Webmastern dabei, ihre robots.txt-Datei zu analysieren und dabei URLs zu identifizieren, die für den Crawler blockiert wurden. Neben der Überprüfung kann man die robots.txt-Datei auch im Editor bearbeiten und live prüfen. Ist die robots.txt fehlerfrei, kann sie heruntergeladen werden und direkt in der eigenen Root-Domain wieder hochgeladen werden. Bing wird im Anschluss automatisch über die Änderung informiert.

Die Ranking-Faktoren

Mittlerweile sind viele Geheimnisse um die Ranking-Faktoren gelüftet. Wie Google, hat auch Bing Ranking-Faktoren, wie Relevanz, Ladezeiten und lokale Faktoren bestätigt.

Auf der BWT-Supportseite hat Bing in der Reihenfolge der Wichtigkeit, die sechs wichtigsten Ranking-Faktoren aufgelistet.

Wir schauen sie uns nochmal genauer an:

Relevanz: Hier prüft die Suchmaschine, wie relevant der Inhalt der Website für die BesucherInnen ist und wie nah dieser an der eigentlichen Suchintention war. Relevant sind vor allem auch die Verwendung von passenden Begriffen und Ankertexten von Links.

Qualität & Glaubwürdigkeit: Die Reputation der Website und die Glaubwürdigkeit der AutorInnen rücken hier in den Fokus. Gemessen wird das unter anderem anhand von Verweisen auf der Seite und Zitaten von Datenquellen.

Freshness bzw. Aktualität: Bing bevorzugt Inhalte, die aktuell und am Puls der Zeit sind. Allerdings macht Bing auch deutlich, dass dies nicht für alle Inhalte zähle. In vielen Fällen kann heute produzierter Inhalt auch noch relevant in einigen Jahren sein.

Lokale Faktoren: Bing berücksichtigt außerdem geografische Faktoren bei den Rankings. So fallen also der Standort der NutzerInnen sowie auch der Hosts ins Gewicht.

Ladezeit: Die Ladezeit einer Seite macht einen wichtigen Teil der User Experience aus. So berücksichtigt Bing auch diesen Faktor beim Ranking, allerdings spielt die Ladezeit ähnlich wie bei Google im Vergleich zu den anderen Faktoren eine eher untergeordnete Rolle.

Der sechste Ranking-Faktor, den Bing auflistet, ist das User Engagement. Beim User Engagement werden die klassischen KPI´s gemessen, wie die Klick- und Absprungrate oder die Verweildauer auf einer Website.

Längst ist dieser Ranking-Faktor auch für Google Thema. Mittlerweile gibt es mehrere Studien und Untersuchungen, die einen Zusammenhang zwischen Website-Aufrufen und Rankings bei Google deutlich aufzeigen. Allerdings hat uns das Google, im Gegensatz zu Bing, noch nie öffentlich bestätigt.

Zusammenfassung

- Die Handhabung und Interface der BWT ist einfach und sehr intuitiv

- Das BWT bietet mehr In-Tool Funktion als GSC, wie z.B.

- Keyword-Planner

- SEO-Report

- Site Explorer

- Die Funktionen in der Such-Performance lässt Wünsche offen:

- Durch fehlende Filtermöglichkeiten werden Teilaspekte der Such-Performance nicht durchleuchtet, wie z.B. Bildersuche

- Außerdem gibt es keine Funktion, die die Performance über bestimmte Zeiträume miteinander vergleicht

Meine persönlichen Highlights:

- Die Site-Scan-Funktion überzeugt:

- Intuitiv bedienbar

- Fehler werden nach Schwerpunkt kategorisiert

- Besonderer Pluspunkt: die leicht verständlichen Handlungsempfehlungen

- Backlink-Analyse glänzt mit besonderen Features:

- Konkurrenz-Vergleich von Backlink-Profilen

- Keyword-Recherche:

- Gerade die Übersicht der Neu-erkannten Keywörter gibt neue Impulse für Keyword-Recherchen

- Site Explorer – absolute Überraschung:

- Überzeugt in der Ansicht und Funktion

- Man bekommt einen wertvollen Einblick, wie Bing Websites crawlt, indexiert und kategorisiert

Bing ist, wie Yandex eine sehr gute Suchmaschine. Es ist für den Markt wenig zuträglich, dass sich die Benutzer zu annährend 100% auf Google festgelegt haben. Dadurch entsteht nicht nur ein gewaltiges Monopol, vielmehr haben kleinere Unternehmen durch die Fokussierung auf nur eine Suchmaschine kaum Chancen etwas von den Besucherströmen ohne PPC zu erhalten.