SEO Auslese Februar 2019

Im Februar führte Google wieder einige neue Funktionen in der Google Search Console ein und das Tool „Test My Site“ zur Überprüfung der mobilen Ladezeit wurde einer Überarbeitung unterzogen. In den Branchen Insights fassen wir unter anderem Maßnahmen zur Erkennung von Sicherheitslücken auf der eigenen Website zusammen.

News der Suchmaschinen

Produktfeed wird für Ranking in der organischen Suche nutzbar

Google kündigte an, dass Produktdatenfeeds zukünftig für das Ranking in den organischen Suchergebnissen verwendet werden können. Dazu muss der Google Shopping Feed für die normale und die Bildersuche freigeschaltet werden und taucht dann – je nach Relevanz für die Suchanfrage – mit in den organischen Suchergebnissen auf.

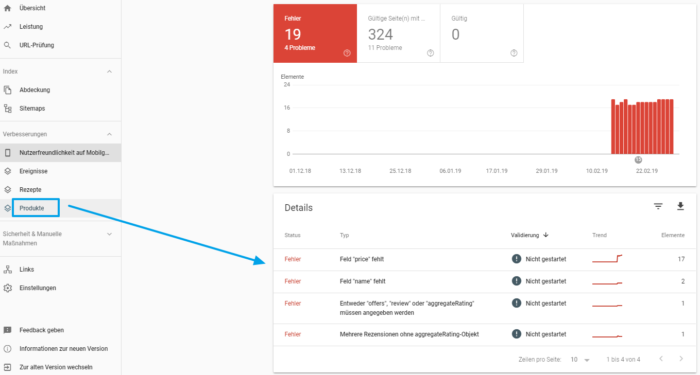

Im Grunde bestand die Möglichkeit bisher schon, die Produkte mittels Markups in die Suche zu bringen. Dazu gibt es in der Search Console unter „Verbesserungen“ auch einen neuen Bericht, in dem Fehler für URLs mit integriertem Product Markup angezeigt werden.

Per Produktfeed sollte es bald für Website-Betreiber wesentlich einfacher sein, ein Häkchen im Merchant Center zu setzen, als alle Produkte mit den richtigen Markups zu versehen. Leider steht diese Möglichkeit vorerst nur in den USA zur Verfügung, andere Länder sollen im Laufe des Jahres folgen.

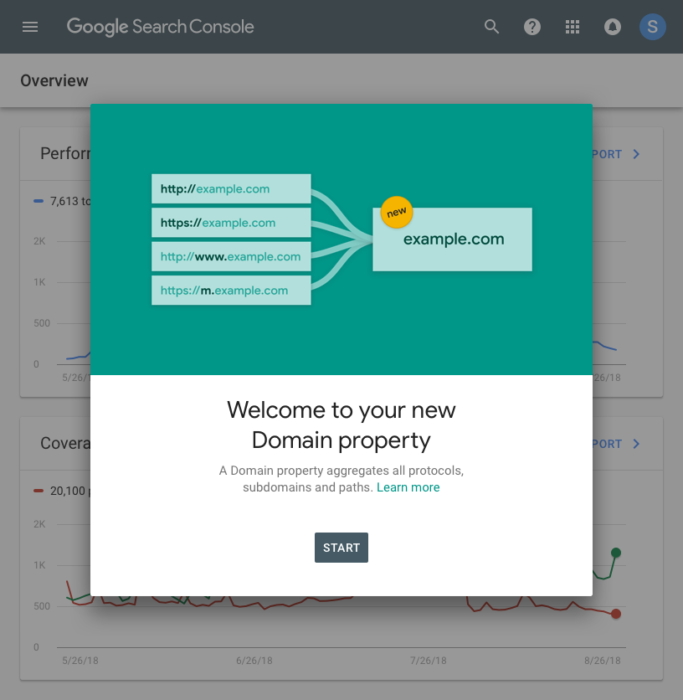

Datenkonsolidierung und Domain Properties in der Google Search Console

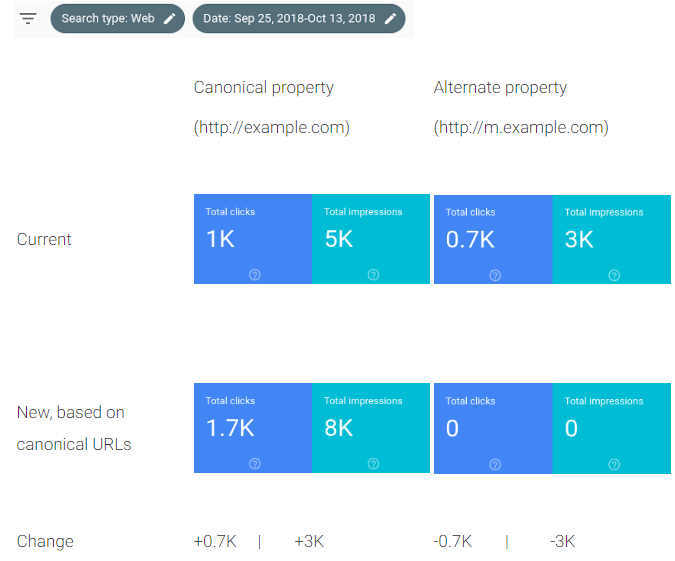

Ab April werden die Leistungsdaten in der Google Search Console nur noch auf den von Google als kanonische URLs bestimmten URLs basieren. Die Umstellung beginnt schon jetzt. Google wird dafür für ein paar Wochen beide Datenansichten zur Verfügung stellen, damit Nutzer den Unterschied verstehen können.

Die Umstellung soll vor allem den Betreibern helfen, die sowohl eine Desktop- als auch eine mobile Seite haben, mehr Überblick über ihre Daten und Mobil-Freundlichkeit zu haben. Aktuell müssen dafür zwei Properties beobachtet werden.

Zusätzlich dazu führt Google nun die bereits angekündigten Domain Properties ein und ersetzt damit die Property Sets. Egal ob http, https oder Subdomains – alle Daten zu diesen Website-Versionen werden in einer Ansicht für die gesamte Domain zusammengefasst. Website-Betreiber sollen dadurch einen Gesamtblick auf die Performance ihrer kompletten Domain bekommen, ohne sich durch einzelne separate Properties in der Search Console klicken zu müssen.

Whitepaper zum Umgang mit Falschinformationen

Google hat ein 30-seitiges Whitepaper veröffentlicht, das den Umgang mit und die Erkennung von Falschinformationen erklärt (bezogen auf YouTube, Google News, die Suche und Ads). Auf den ersten Blick enthält es keine brandneuen Informationen, sondern fasst den kompletten Sachverhalt einmal gebündelt zusammen.

Best Practices für eine gute User Experience

Bereits Ende letzten Jahres hat Google acht sogenannte „UX Playbooks“ veröffentlicht. Darin werden für verschiedene Branchen Best Practice Beispiele für eine gute Usability beschrieben und visuell gezeigt sowie erläutert, wie grundlegende Funktionen (Suche, Navigation etc.) idealerweise eingesetzt werden. Für folgende Branchen können die UX Playbooks aktuell heruntergeladen werden:

- UX Playbook Cars / Auto

- UX Playbook Content / News

- UX Playbook Finance

- UX Playbook Healthcare

- UX Playbook LeadGen

- UX Playbook Real Estate

- UX Playbook Retail

- UX Playbook Travel

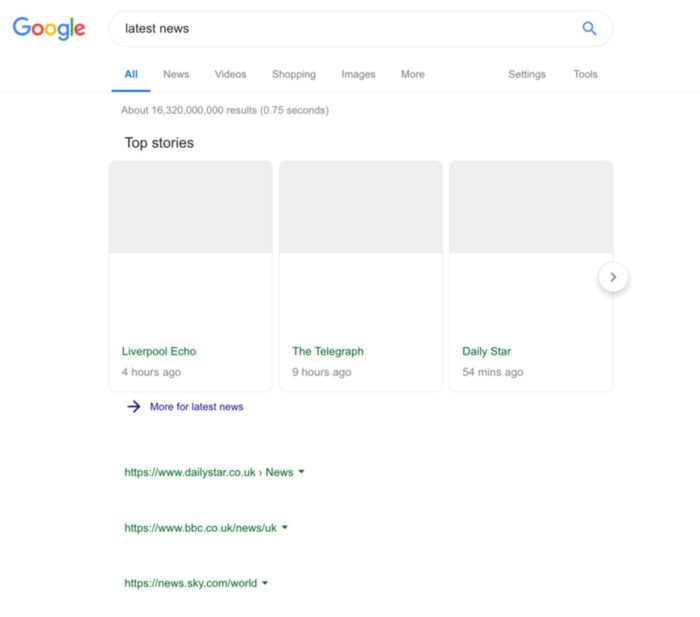

Leistungsschutzrecht ließe Suchergebnisse leer aussehen

Neues zum geplanten Leistungsschutzrecht: Google hat im Januar mal getestet, wie die Suchergebnisse aussehen könnten, falls das Gesetz in Kraft treten sollte. Nun ja… es wäre sehr leer. Nutzerzahlen gingen Schätzungen zufolge um 45 Prozent zurück, stattdessen verlagerte sich der Traffic auf Social-Media-Plattformen und wenige große Portale. Google spricht sich daher für eine deutlich mildere Form des Leistungsschutzrechtes aus.

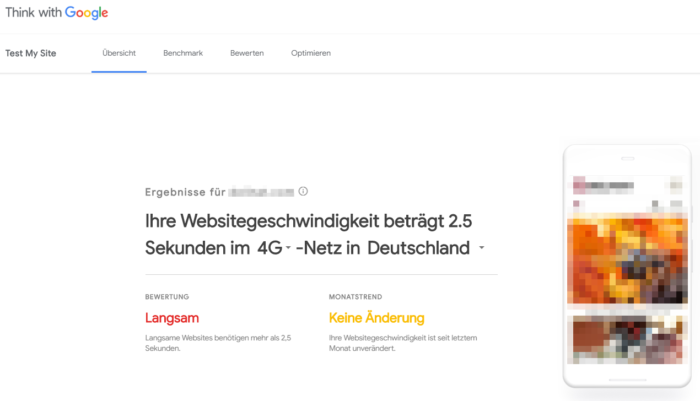

Neue Version von Googles “Test my Site” Tool

Im Rahmen des Mobile World Congress in Barcelona hat Google eine neue Version des bereits bekannten Tools „Test My Site“ vorgestellt. Mit dem Tool kann die mobile Ladezeit einer Website getestet werden. Neu ist, dass bei Wiederholung der Analyse auch ein Monatstrend angezeigt wird. Außerdem kann ein Vergleich mit der Konkurrenz durchgeführt werden, und es werden direkt Optimierungsempfehlungen zur Verbesserung der Ladezeit angezeigt. Zudem kann ein kostenloser Bericht angefordert werden.

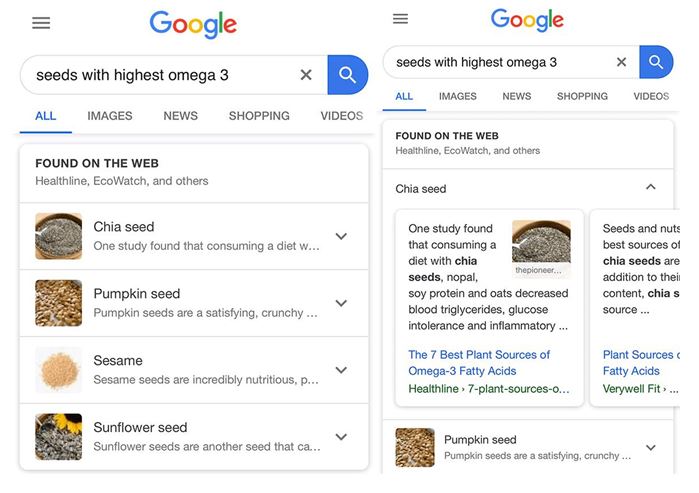

Tests zu Featured Snippets aus verschiedenen Website-Quellen

Google testet jetzt auch Featured Snippets, die aus den Inhalten mehrerer Seiten bestehen. Werden wir also bald nicht mehr nur um Platz 1 kämpfen, sondern auch um Platz 1 im Featured Snippet? Derweil hat die Entdeckung eine kleine Diskussion in der Branche losgetreten. Einige werfen Google vor, damit nun auch Antworten auf komplexere Fragen zu geben, indem Google sich aus verschiedenen Quellen bedient und die Suchenden noch seltener die Suchergebnisse anklicken.

Vorsicht bei internen Links mit Parametern

Google hat Probleme mit internen Links, wenn Parameter (wie z.B. „utm“ zum Tracking) eingesetzt werden. Eventuell werden dann sogar die Versionen mit Parameter indexiert. Auch wenn dort ein Canonical Tag mit Verweis auf die URL ohne Parameter hinterlegt ist, könnte das ignoriert werden. Hintergrund ist, dass Google interne Links und Canonical-Links als starke Signale für die Aufnahme in den Google-Index wertet.

Google Chrome ermöglicht die Verlinkung von Textstellen

Der Chrome Browser soll neben dem Abspeichern von kompletten Websites bald auch die direkte Verlinkung einzelner Abschnitte einer Website ermöglichen. Nutzer sollen dafür einen Bereich markieren und diesen dann inklusive Link teilen können. Über angehangene Parameter kann der Chrome Browser Anfang und Ende des Website-Abschnittes identifizieren und beim Empfänger den markierten Bereich genauso anzeigen.

Local SEO News

Augmented Reality Funktion für Google Maps

Ausgewählte Local Guides testen eine spannende Funktion in der Google Maps App: Die Navigation mittels Augmented Reality. Dabei wird nach Eingabe der Zieladresse die Kamera gestartet und es legt sich ein AR-Layer über den Sucher. Wer zu Fuß unterwegs ist, soll sich somit besser zurechtfinden können. Experten vermuten, dass diese Funktion auch in Autos zum Einsatz kommen könnte.

Google My Business: Tipps für das Antworten auf Rezensionen

Bisher konnten Unternehmen nur via Google My Business-Oberfläche oder App auf Rezensionen reagieren. Google hat nun die Funktion eingeführt, dass die Beantwortung auch über die Desktopversion von Google Maps vorgenommen werden kann.

Daneben hat Google seine Hilfeseiten aktualisiert und gibt Unternehmen Tipps für das Antworten auf positive und negative Rezensionen, darunter z.B.:

- Freundlich antworten und nicht persönlich werden

- Kurze Antworten schreiben

- Dem Rezensenten für die Bewertung danken

- Nicht werblich antworten

Branchen Insights

Website-Sicherheit auch für SEO besonders wichtig

Ein leicht mahnender Artikel für die SEO-Arbeit: William Chalk von Search Engine Watch plädiert dafür, dass das Thema Website-Sicherheit einen stärkeren Platz in der SEO-Arbeit haben sollte. Er sieht vor allem Potenzial, sich damit von Konkurrenten abzuheben.

Die Zahl der Hackerangriffe wird nicht weniger und hatte in den letzten Jahren häufig einen sehr starken Einfluss auf den Traffic. Sicherheit ist ein wesentlicher Rankingfaktor, was sich an der Wichtigkeit von HTTPS gezeigt hat. Damit hört die Arbeit aber nicht auf. Unabhängig von der HTTPS-Zertifizierung zeigen Untersuchungen, dass auf den meisten Websites durchschnittlich 58 Angriffe pro Tag stattfinden.

Ein weiteres Problem: Suchmaschinen haben nur einen Bruchteil der Gesamtzahl der mit Malware infizierten Websites auf die schwarze Liste gesetzt. Laut eines aktuellen Berichts wurden in 90 Prozent der Fälle infizierte Websites überhaupt nicht identifiziert, der Betreiber ist also unbekannt.

Welche Ansatzpunkte gibt es für die Erkennung von Sicherheitslücken:

- Bots: 19% aller Bots werden für das Crawling genutzt, um Schwachstellen an einer Seite zu finden, um daraufhin einen Hack-Angriff durchzuführen. Sollten in der Search Console viele 404 oder 5xx Codes auffallen, dann ist das ein Anzeichen dafür, dass der Server aufgrund sehr hoher Anfragen überlastet war. Das kann aber auch ein „guter“ Bot sein, der die Website mal stärker crawlt. Aus diesem Grund sollte man überlegen, den „guten“ Bots (Google, Bing usw.) ein Crawl-Limit zu setzen. Sollten danach immer noch viele 5xx Codes auftauchen, könnten negative Bots am Werk sein.

- Backlinks von Linkfarmen oder Traffic-starken Seiten (Casinos z.B.), die auf die eigene Website verlinken. Hier erkennt man schnell im Google Analytics am Referrer Traffic, ob etwas unnatürlich ist. Empfehlung: Alert einrichten und eine DMCA-Beschwerde bei Google einreichen.

- Logfile Analysen lassen sich nicht umgehen. Um herauszufinden, welche Bots die Website besuchen, sollten diese analysiert werden. Die normale Bot-Bandbreite sollte einige Megabytes pro Monat nicht überschreiten. Folgendes Tool, welches nur die Bots auflistet, wird empfohlen: https://awstats.sourceforge.io/

- Veraltete WordPress Themes und Plugins sind durch deren Sicherheitslücken eine willkommene Einladung für Hacker. Sie sollten daher stets aktuell gehalten werden.

- Es gibt kostenpflichtige Dienste wie WebsitePulse oder SiteLock, die eine Softwarelösung für die Überwachung des Standorts, Servers und Anwendungen anbieten. Es gibt auch Tools, die Änderungen am Quellcode überwachen.

- Lokale Netzwerksicherheit verwalten: Dazu gehören die Verschlüsselung mittels VPN, Anzahl der möglichen Anmeldeversuche in einem bestimmten Zeitraum begrenzen, abgelaufene Sitzungen automatisch beenden, das automatische Ausfüllen von Formularen vermeiden, Web Application Firewall (WAF).

Tragen trafficstarke Backlinks zu einem höheren Ranking bei?

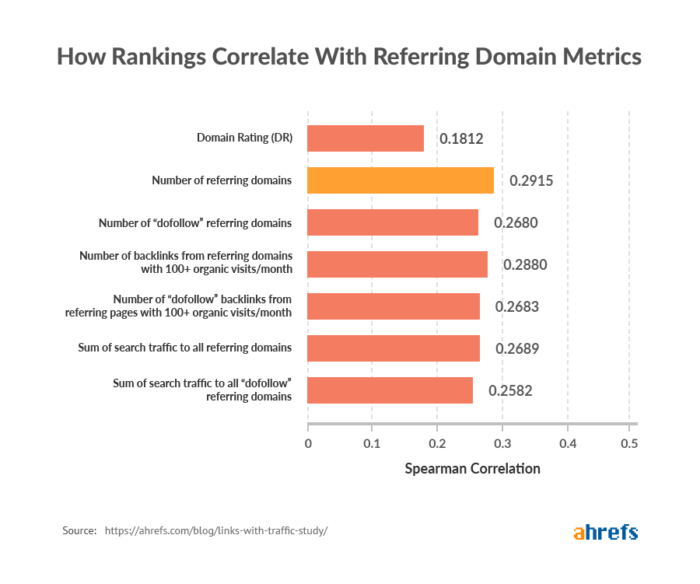

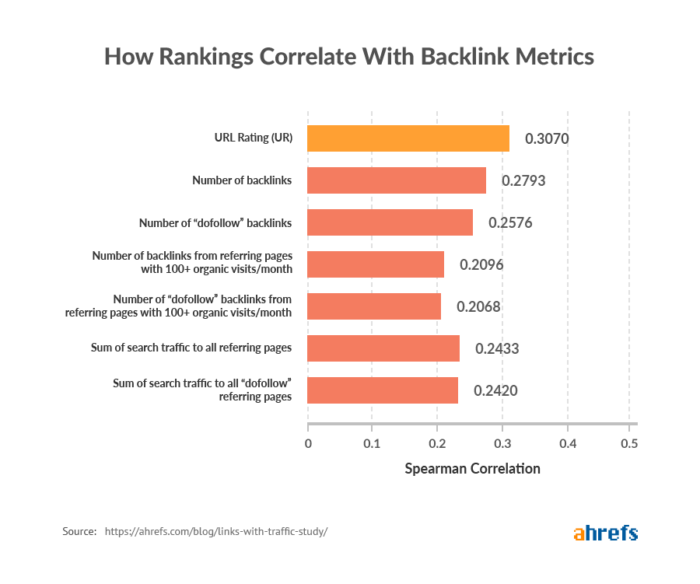

Ahrefs hat mithilfe einer Studie untersucht, ob Links von trafficstarken Seiten möglicherweise mehr Gewicht haben könnten.

Was wurde untersucht? Es wurden 44.589 Non-Brand Keywords mit einem Suchvolumen zwischen 2.000 und 5.000 ausgewählt und dafür die Top 10 Ergebnisse genauer betrachtet. Dabei wurden verschiedene Daten erhoben und geprüft, ob eine Korrelation vorliegt.

Ahrefs hat dabei Aspekte wie das URL-Rating, die Anzahl der Backlinks, die Anzahl der Backlinks mit dofollow, die Anzahl der Backlinks von Seiten mit +100 organischen Traffic im Monat etc. betrachtet:

Firstly, the correlation for the number of “dofollow” backlinks is a little bit weaker than that of the total number of backlinks. This could be an indication that Google values some nofollowed links from strong pages more than followed links from weak pages.

Zudem liege die Vermutung nahe, dass Links von leistungsstärkeren Seiten mehr Gewicht haben, als Links von Seiten mit relativ wenig Such-Traffic. Die gleiche Untersuchung wurde auch nochmal für Domains gemacht:

Hier fällt auf, dass die Anzahl an Referring Domains mit Traffic keine größere Korrelation hat als die Anzahl aller Referring Domains. Bahnbrechende Erkenntnisse bringt die Studie nicht. Es lassen sich dennoch folgende Punkte ableiten:

- Es gibt nicht DEN einen Faktor, der die Qualität eines Links bestimmt (alle Korrelationen sind in einem ähnlichen Bereich).

- Dadurch ist es auch schwer zu sagen, welche Faktoren für eine gute und welche für eine schlechte Qualität eines Backlinks sprechen.

Branchen News kurz & knapp

- Affiliate Peer Wandiger hat sich in einem spannenden Artikel mit der Wirkung eines angezeigten bzw. nicht angezeigten Datums bei Blogbeiträgen in der Google Suche beschäftigt.

- MOZ erklärt die Identifizierung und den Umgang mit Keyword Kannibalisierung.

- Search Engine Journal zeigt verschiedene Wege auf, wie lokale Suchergebnisse manuell und automatisch auf Länder-, Region- und Stadtebene überprüft werden können.

- Das kostenlose Keyword-Tool „Ubersuggest“ wurde von Neil Patel komplett überarbeitet und bietet neben Keywordvorschlägen nun weitere Funktionen an, darunter z.B.: das Suchvolumen der letzten Monate zum Keyword, die Konkurrenzsituation und welche Seiten damit in den SERPs ranken. Zudem kann auch eine Domain im Tool eingegeben werden. Zu dieser wird dann angezeigt, für wie viele Keywords sie rankt, wie viel SEO-Traffic sie bekommt, wie viele Backlinks, was die Top-Seiten sind etc.

- ahrefs zeigt im Blog, wie man einen grundlegenden Website Audit durchführt. Für einige Punkte benötigt man natürlich auch das Tool selbst. ????

- Search Engine Journal stellt eine 12-Schritte-Anleitung vor, die man vor dem Crawl einer Website beachten sollte.

- MOZ hat sich mit Voice Search beschäftigt und herausgefunden, dass Google scheinbar noch Probleme damit hat, Folgefragen richtig zu deuten.

- Bloofusion stellt in einem Video einige Screaming Frog Hacks vor.