SEO Auslese Mai 2018

Im Mai hat Google wieder intensiv an seinen Tools geschraubt und es gibt einige spannende Neuerungen. So wartet Google Trends nun mit einer überarbeiteten Bedienoberfläche und neuen Features auf interessierte SEOs. Google My Business unterstützt Agenturen und ruft ein Partnerprogramm ins Leben. Zudem wurden die Bildersuche-Richtlinien angepasst. Außerdem fassen wir euch hilfreiche Tipps zu PDF-Rankings und den Umgang mit umfangreichen Webseiten zusammen. Ausführliche Informationen erfahrt ihr in unserer aktuellen SEO Auslese.

News der Suchmaschinen

Google arbeitet wieder mit kürzeren SERP-Snippets

Im Dezember 2017 hatte Google die Länge der Snippets auf bis zu vier Zeilen angepasst. Im Mai wurde diese Anpassung jedoch wieder rückgängig gemacht, davon berichtete Searchengineland. Snippets haben nun wieder zwei Zeilen und entsprechen damit dem Niveau vor der Umstellung.

Googles Sprachrohr Danny Sullivan sagte zu dieser Änderung, dass es keine maximale Länge für Snippets gibt, sondern dass diese dynamisch von Google generiert werden.

Our search snippets are now shorter on average than in recent weeks, though slightly longer than before a change we made last December. There is no fixed length for snippets. Length varies based on what our systems deem to be most useful.

— Danny Sullivan (@dannysullivan) 14. Mai 2018

Im Beitrag von Searchengineland wird auf eine kürzlich veröffentlichte Studie des SEO-Plugin-Anbieters Yoast hingewiesen, die zeigt, dass Google sowieso bewusst Inhalte von der Webseite verwendet, um die Meta-Description zu befüllen. Es besteht also kein Grund, die eigenen Snippets sofort wieder anzupassen.

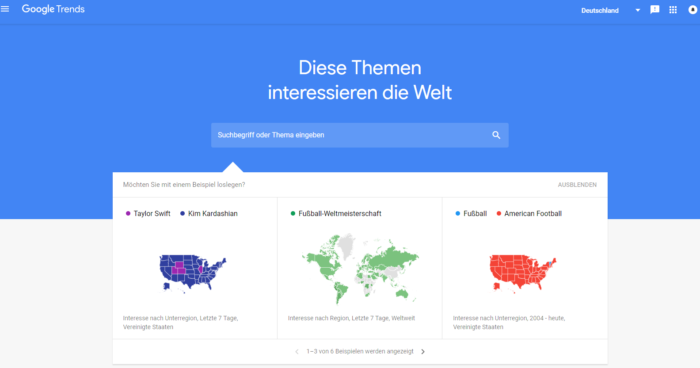

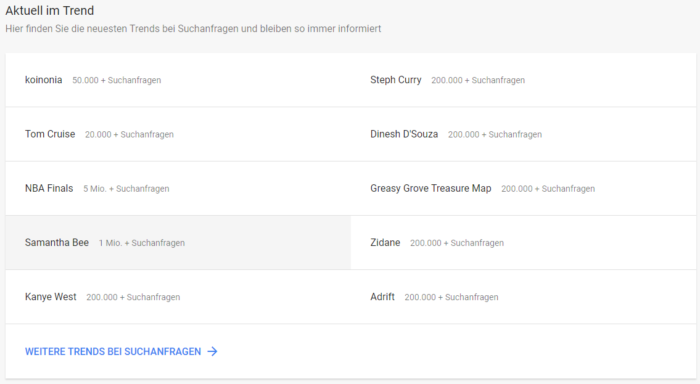

Google Trends mit schickerer Bedienoberfläche und neuen Features

Google Trends hat nicht nur ein Update seiner Bedienoberfläche erhalten, es wurden auch einige neue Features hinzugefügt.

Bei Searchenginejournal gibt es eine Zusammenfassung zu den Änderungen. So gibt es nun weitere Möglichkeiten zum Erkunden von Daten. Im Bereich „Aktuell im Trend“ lassen sich die angesagtesten Suchanfragen auf Tages- und Minutenbasis einsehen. Zudem kann jetzt auf einen neuen Bereich mit aktuellen Meldungen und Stories zugegriffen werden, der vom Google News Lab zusammengestellt wurde. Es besteht die Möglichkeit, Suchtrends bis ins Jahr 2001 zurückzuverfolgen, und es stehen neue Typen von Infografiken zur Verfügung.

Empfehlung Subdomain oder Verzeichnis

Das Thema Subdomain vs. Unterverzeichnis haben wir bereits in vergangenen Auslesen behandelt, da es immer wieder zu Diskussionen in der SEO-Branche kommt. John Müller hat in einem kürzlichen Webmaster Hangout eine Empfehlung dazu gegeben: Ein Unterverzeichnis sollte dann gewählt werden, wenn Inhalte thematisch nah beieinander sind. Die Verwendung einer Subdomain ist im Falle von inhaltlichen Unterschieden sinnvoller. Bei Unsicherheit bezüglich der besten Wahl empfiehlt John Müller auf Unterverzeichnisse zurückzugreifen, beide Lösungen sind jedoch in Ordnung.

Aktualisierung der Richtlinien für die Google-Bildersuche

seo-portal.de berichtete im Mai von der Anpassung der Richtlinien für die Google-Bildersuche. Diese finden sich auf den Hilfeseiten für die Google Search Console. Zusammengefasst sollten laut Google folgende Punkte beachtet werden:

- Das Bild sollte zum Kontext der Seite passen und in der Nähe von relevantem Text platziert werden.

- Da Google Title- und Description-Tag für die Bildersuche verwendet, sollten diese Angaben stimmig sein.

- Produkte, Videos und Rezepte sollten mit strukturierte Daten versehen werden, damit sie als Rich Snippets ausgespielt werden können.

- Für eine schnelle Ladezeit der Seite sollten die neueste Bildoptimierung und responsive Bilder verwendet werden.

- Weiterhin sind Faktoren wie Titel, Beschriftung, Dateiname und Text für Google wichtig. Der Dateiname sollte daher sprechend sein. Der Alt-Text sollte informativ und nicht keyword-spammig sein.

Indexierung von JavaScript-Seiten benötigt mehrstufigen Prozess

Um JavaScript-Inhalte zu crawlen, benötigt Google deutlich mehr Rechenleistung. Aufgrund von Ressourcenproblemen seitens Google kann die Indexierung dieser Inhalte daher mehrere Tage in Anspruch nehmen, berichtet SEO Südwest. Google crawlt in diesem Zusammenhang in mehreren Schritten. Zuerst werden die serverseitig gerenderten Inhalte abgerufen, danach erfolgt eine initiale Indexierung. Der clientseitige Quellcode wird erst interpretiert und demnach weitere Inhalte indexiert, wenn genügend freie Rechenkapazitäten zur Verfügung stehen.

Durch diesen Prozess können unvollständige Seiten vorzeitig im Index landen, was z.B. bei Nachrichtenportalen (Aktualitätsfaktor) problematisch sein könnte. Wer also an einer schnellen und vollständigen Indexierung seiner Inhalte interessiert ist, sollte auf statisches HTML setzen.

Google My Business News: Partnerprogramm für Agenturen & neue Struktur bei Maps

Bei Google My Business gibt es aktuell viel Bewegung. Im Blog von Google wurde im Mai berichtet, dass Agenturen nun die Möglichkeit haben, sich für ein Google My Business Konto zu registrieren. Damit erhalten sie ein eigenes Dashboard und können mehr als 100 Standorte verwalten.

Um die Agenturen zu unterstützen, startet Google ein neues Partnerprogramm. Vertrauenswürdige Partner erhalten dann schon einen Vorab-Zugriff auf neue Google My Business Funktionen, ebenfalls einen Partner-Manager und eine Vorstellungsmöglichkeit auf der Google My Business Webseite.

Laut Google werden für die Auswahl der Agenturen für dieses Programm mehrere Kriterien berücksichtigt, die allerdings noch nicht bekannt sind.

Google Maps erhält einen neuen Namen, eine neue Preisgestaltung und eine neue Struktur. Die Plattform wird künftig aus den drei Bereichen Maps, Routes und Places bestehen. Google führt dabei vor kurzem veröffentlichte APIs unter der neuen Google-Maps-Plattform zusammen.

Außerdem wurde im Mai noch auf Searchenginejournal berichtet, dass Nutzer nun benachrichtigt werden, wenn ein Unternehmensinhaber auf ihre Rezension geantwortet hat.

Branchen Insights

SEO-Expertentipps für große Webseiten

Bei Sistrix haben fünf Branchen-Experten ihr Wissen zu SEO für umfangreiche Webseiten zusammengetragen. Im Beitrag sind Video-Interviews mit den Experten verlinkt, die über SEO-Skills für große Webseiten, die Zusammenarbeit mit Agenturen und externen Beratern, SEO in großen Unternehmen sowie die Zukunft für große Webseiten sprechen.

Zudem werden im Artikel einige Tipps zu ausgewählten Onpage-Themen gegeben, die für umfangreiche Webseiten wichtig sind. Eine kleine Auswahl fassen wir im Folgenden für euch zusammen:

- Hinsichtlich Crawling und Indexierung lohnt sich die Aufteilung in Themen-Cluster, sodass Verlinkungen innerhalb und zwischen diesen Clustern systematisch aufgebaut werden können.

- Werden unterschiedliche Medien wie Videos oder Bilder genutzt, dann sollten dafür auch jeweils separate Sitemaps angelegt werden. Es wird empfohlen, diese algorithmisch zu erstellen, nicht händisch.

- Um den Googlebot zu steuern und zu überwachen, kann eine Logfile-Analyse hilfreich sein. Ebenfalls Probleme beim Crawling aufdecken kann die Simulation des Googlebots durch einen externen Crawler, den man über die Seite schickt.

- Hinsichtlich der internen Verlinkung sollte eine automatisierte Lösung geschaffen werden. Vorteilhaft ist dabei, wenn sich die Inhalte in Silos aufteilen lassen oder eine breite Navigation (z.B. über ein Mega Menu) angelegt wird. Zudem sollten trafficstarke Seiten verlinkt werden, bei deren Identifizierung die Analytics Kennzahlen behilflich sind.

- Die interne Suche sollte aktiv ausgewertet werden, um Erkenntnisse zu stark frequentierten, aber gegebenenfalls schlecht verlinkten Seiten zu gewinnen. Außerdem lassen sich Suchanfragen identifizieren, zu denen kein internes Suchergebnis ausgeliefert werden konnte und Inhalte bereitgestellt werden sollten.

- Bezüglich der Internationalisierung einer umfangreichen Webseite ist es vorteilhaft, wenn die Länderseiten eine identische Struktur aufweisen, um eine saubere Zuordnung der Inhalte untereinander umzusetzen.

Viele weitere Expertentipps liefert der Artikel in seiner ausführlichen Form.

Wann PDF-Dateien im SEO problematisch sind

Markus Hövener (Geschäftsführer von Bloofusion) hat einen Artikel zu PDF SEO veröffentlicht. Dabei werden Fragen beantwortet, wann PDFs problematisch und welche Maßnahmen sinnvoll sind, um die Rankings zu verbessern.

Nachteilig sind PDF Rankings seiner Einschätzung nach aus folgenden Gründen:

- Suboptimale Nutzererfahrung (besonders auf mobilen Endgeräten), da PDFs meist kein Menü haben und somit keine Möglichkeit besteht, auf eine weiterführende Seite zu gelangen.

- Bei großen PDF-Dateien kann es zu Problemen mit dem Crawl-Budget und einer erhöhten Server-Last kommen.

- Die Auswertung des Traffics ist problematisch, da das Tracking von Web-Analyse-Diensten wie Google Analytics nicht bei PDFs funktioniert. Die Google Search Console schafft hier jedoch Abhilfe.

Mithilfe der Site-Abfrage „filetype:pdf site:www.meinewebsite.de“ und über die Google Search Console kann herausgefunden werden, ob PDF-Dateien der eigenen Webseite im Index sind und wie viele Klicks diese haben. Dabei sollte zudem geprüft werden, ob vorhandene PDFs gegebenenfalls mit HTML-Inhalten konkurrieren und somit keinen Mehrwert für den Nutzer bieten.

Schlussendlich können nicht relevante PDF-Dateien per robots.txt gesperrt werden. Eine weitere Maßnahme ist, in der Google Search Console zu prüfen, für welche Suchbegriffe PDFs gefunden werden und für diese dann HTML-Inhalte zu erstellen.

Branchen News kurz & knapp

- SEMrush hat eine größere Fallstudie zu Featured Snippets für den Mobile-Bereich erstellt. Interessierte Leser können sich ein Featured Snippet Cheat Sheet mit der Zusammenfassung der Ergebnisse der Studie herunterladen.

- T3N hat sich in einem Blogpost mit Zielsetzung und strategischer Ausrichtung von Progressive-Web-Apps für Unternehmen beschäftigt.

- Einen umfangreichen Guide zur Google Search Console, ebenfalls mit ein paar weiterführenden Tipps für fortgeschrittene Nutzer, gibt es bei backlinko.com.

- Moz hat die Änderung der Descriptions direkt in einem Blogpost aufgegriffen und eine Anleitung geschrieben, wie man unter ständig wechselnden Bedingungen Meta-Descriptions schreiben sollte.

- Videos mit schema.org auszeichnen – im SEMrush Blog wird’s erklärt.

- Martin Mißfeldt hat beobachtet, dass weniger Featured Snippets ausgespielt werden. Stattdessen werden mehr Ergebnisse unter dem Feld „Nutzer fragen auch“ angezeigt.

- Im Tool von ryte gibt es jetzt den neuen Kannibalisierungs-Report. Gleichzeitig haben sie noch einen Artikel dazu veröffentlicht, was Keyword-Kannibalisierung ist und wie diese Probleme zu beheben sind.

- Seokratie gibt einen kurzen Überblick, welche Zahlen man im SEO monitoren sollte, inklusive zugehöriger Tools.

Content Marketing kurz & knapp

- Das Content Marketing Institute hat ein paar kostenlose Tools für die Content-Planung vorgestellt. Besonders spannend finden wir das Tool Mintent. Ein kostenloser Redaktionsplaner, der auf den ersten Blick ziemlich viele gute Sachen verspricht und die Teamarbeit maßgeblich verbessert.

- Cooler Content-Ansatz: Storydoing ist gewissermaßen die Evolution des Storytelling. Anstatt nur von Unternehmensvisionen zu reden, setzt man beim Storydoing seine Unternehmenswerte kreativ mit Events, Kunstinstallationen oder Ähnlichem um.

- ryte stellt in einem Artikel verschiedene Wege vor, wie und warum man Content wiederverwerten sollten.

- „Manchmal braucht es also eine Virtual-Reality-Brille, um etwas zu sehen, vor dem wir so oft die Augen verschließen.“ Tierschutz und Virtual Reality – man spricht mit einem Tier, welches im Labor gehalten wird. Es wird dieses Mal nicht auf den Schockmoment gesetzt, wie es Peta sonst immer tut, sondern auf Aufklärung.

[…] Zeichenanzahl der Meta-Description auf 320 Zeichen verdoppelt und diese Änderung dann im Mai wieder rückgängig gemacht. Auch damals gab es keine offizielle Aussage zur Anpassung seitens […]